Heuschnupfen: Warum Pollenallergiker jetzt schon leiden

Diverse Untersuchungen zur Verbreitung von Mikroplastik im menschlichen Körper geraten inzwischen unter Druck. Die oft erschütternden Ergebnisse dieser Forschungsarbeiten könnten grö߭tenteils schlicht auf Verunreinigungen oder fehlerhaften Messmethoden beruhen. (Weiter lesen)

Diverse Untersuchungen zur Verbreitung von Mikroplastik im menschlichen Körper geraten inzwischen unter Druck. Die oft erschütternden Ergebnisse dieser Forschungsarbeiten könnten grö߭tenteils schlicht auf Verunreinigungen oder fehlerhaften Messmethoden beruhen. (Weiter lesen)

Der Beitrag ChatGPT Health: Fehldiagnosen im Premium-Gewand erschien zuerst beim Online-Magazin BASIC thinking. Über unseren Newsletter UPDATE startest du jeden Morgen bestens informiert in den Tag.

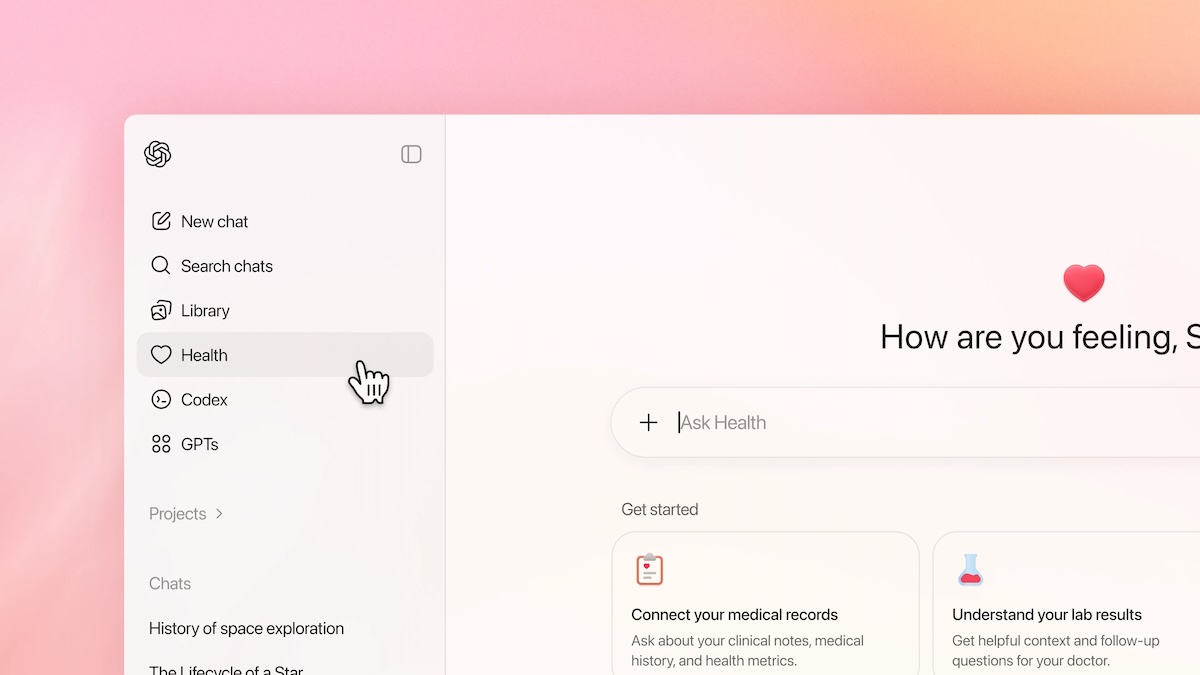

OpenAI fügt ChatGPT einen neuen Gesundheits-Tab hinzu, über den Nutzer elektronische Krankenakten hochladen und Verbindungen zu Gesundheits- und Fitness-Apps herstellen können. Die Reaktionen auf ChatGPT Health fallen jedoch gemischt aus. Eine kommentierende Analyse.

OpenAI betont, dass ChatGPT Health trotz der engen Zusammenarbeit mit Ärzten keine Diagnosen stellen oder Behandlungen empfehlen darf. Das Tool soll offiziell lediglich zur Information und Vorbereitung von Arztbesuchen dienen.

Das ist vor allem rechtlich relevant, da OpenAI ChatGPT Health in den USA als Verbraucherprodukt einstufen lassen hat. Damit fällt die Funktion nicht unter die strengen Datenschutzgesetze für das Gesundheitswesen. Das entbindet OpenAI von gewissen Haftungsrisiken und verlagert die Verantwortung vor allem auf die Nutzer.

Innerhalb der EU wäre das sicher nicht möglich – und das ist auch gut so. Denn trotz Verbesserungen und ärztlichen Analysen sind Falschinformationen in Form von KI-Halluzinationen keinesfalls komplett ausgeschlossen. In puncto Datenschutz gibt es ebenfalls Bedenken.

OpenAI bietet zwar eine Zweck-Verschlüsselung an, aber eben keine Ende-zu-Ende-Verschlüsselung, wie sie bei Messenger-Diensten üblich ist. Heißt konkret: Es besteht zwar ein Schutz vor Fremdzugriffen. OpenAI kann die Daten jedoch einsehen.

Da Millionen Nutzer ChatGPT trotz einhelliger Warnungen nach wie vor zu Gesundheitsfragen konsultieren, ist es zunächst einmal begrüßenswert, dass sich OpenAI dem Thema angenommen hat, um den Chatbot zu verbessern.

Doch das Unternehmen suggeriert auch einen Gesundheitsberater, der ChatGPT niemals sein kann. Die externe Aufklärung von Nutzern wird deshalb genauso entscheidend sein, wie die Frage, ob der Chatbot tatsächlich genügend Warnhinweise an den richtigen Stellen ausspuckt und wie er mit hochsensiblen Gesundheitsthemen umgeht.

Dass eine Verarbeitung von ärztlichen Patientendaten in der EU nicht möglich ist, deutet auf regulatorische Hürden hin. Denn: In Deutschland unterliegen Gesundheitsdaten glücklicherweise strengen Verarbeitungsvoraussetzungen. Vermutlich wird OpenAI solche Daten in den USA nutzen, um personalisierte Werbung zu schalten. Vollständiger Datenschutz ist nicht garantiert.

Auch interessant:

Der Beitrag ChatGPT Health: Fehldiagnosen im Premium-Gewand erschien zuerst auf BASIC thinking. Folge uns auch auf Google News und Flipboard oder abonniere unseren Newsletter UPDATE.