Natrium-Ionen-Batterie: Wasser-Trick verdoppelt Leistung

Der Beitrag Natrium-Ionen-Batterie: Wasser-Trick verdoppelt Leistung erschien zuerst beim Online-Magazin BASIC thinking. Über unseren Newsletter UPDATE startest du jeden Morgen bestens informiert in den Tag.

Natrium-Ionen-Batterien dienen nicht nur als Energiespeicher, sondern verwandeln Meerwasser ganz nebenbei in Trinkwasser. Forscher haben nun herausgefunden, dass ein bekannter Batteriewerkstoff deutlich besser funktioniert, wenn sein Wassergehalt erhalten bleibt.

Forscher der University of Surrey machten kürzlich eine überraschende Entdeckung, die Natrium-Ionen-Batterien erheblich verbessern könnte. Bisher haben Wissenschaftler das in den Batterien enthaltene Wasser durch Erhitzen mühsam entfernt, da sie eine Beeinträchtigung der Leistung vermuteten. Eine neue Studie belegt jedoch, dass der Verbleib des Wassers im Material die Energiespeicherung nahezu verdoppeln kann.

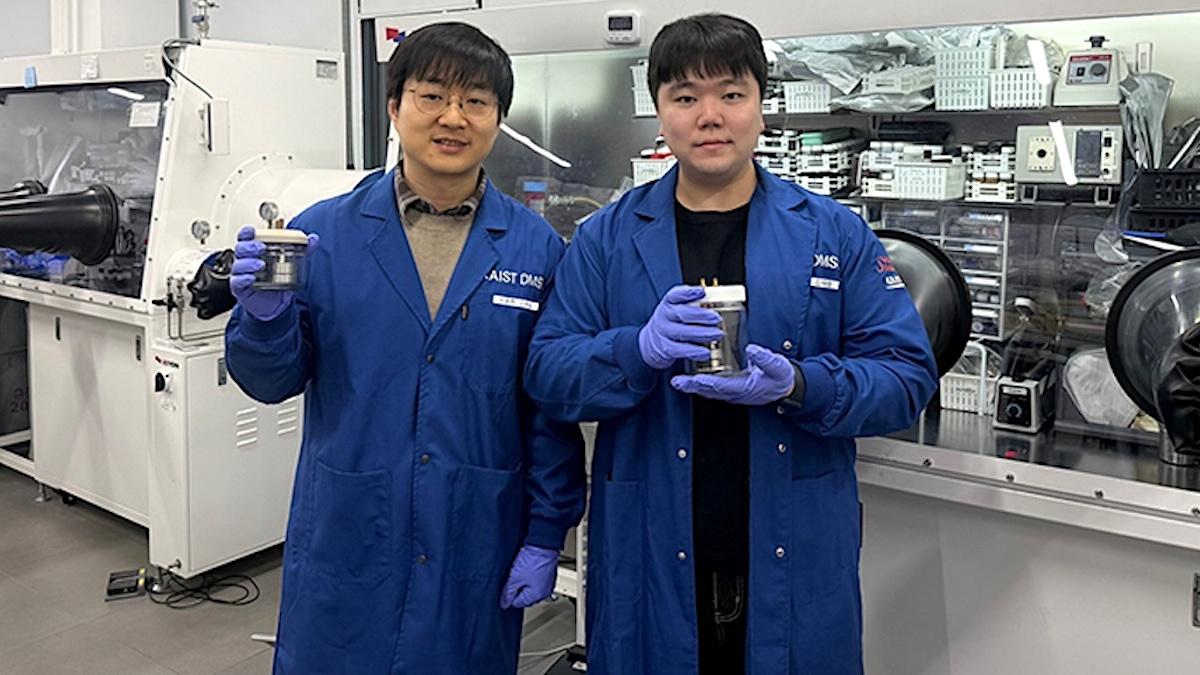

Das Team nutzt ein spezielles Material namens Nanostructured Sodium Vanadate Hydrate (NVOH). Durch den Verbleib des Wassers im NVOH erreichte das System eine deutlich höhere Ladegeschwindigkeit und eine stabilere Nutzung im Alltag. In Testreihen überstand die Batterie mehr als 400 Ladezyklen ohne nennenswerte Verluste.

Sauberes Wasser durch Energiespeicherung

Das Material zählt damit zu den bisher leistungsstärksten Kathoden für Natrium-Systeme. Natrium bietet der Industrie gegenüber Lithium entscheidende Vorteile, da es überall auf der Welt im Überfluss vorkommt. Das senkt die Anschaffungskosten für Speichertechnologien und schont gleichzeitig die Umwelt.

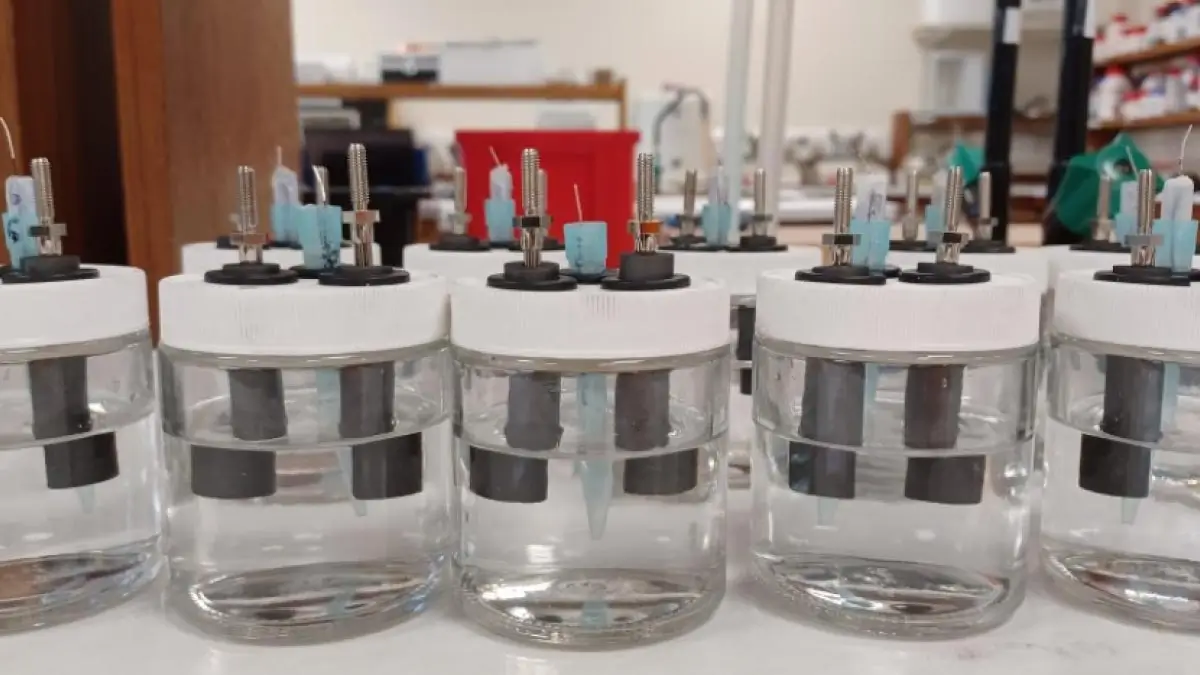

Ein besonderer Durchbruch gelang den Forschern durch die Vielseitigkeit des Systems, das sogar in gewöhnlichem Salzwasser funktioniert. Während die Batterie Energie speichert, zieht sie aktiv das Natrium aus der Umgebungslösung. Wissenschaftler nennen diesen doppelten Nutzen eine elektrochemische Entsalzung.

Eine Elektrode aus Graphit extrahiert dabei das Chlorid aus dem Wasser. Dadurch gewann das Team frisches Trinkwasser aus ungenießbarem Meerwasser. Dieser Prozess läuft parallel zur Speicherung ab und macht die Anlage zu einem multifunktionalen Werkzeug für Küstenregionen.

Sichere Natrium-Ionen-Batterien im Alltag

In Sachen Sicherheit überzeugt die neue Technologie durch eine stabile chemische Reaktion. Bei Tests mit einem Universalindikator färbte sich das Salzwasser an der Gegenelektrode rot. Das beweist, dass das System kein Gas entwickelt, was ein wichtiges Argument für die sichere Anwendung im Alltag ist.

Die Abwesenheit von gefährlicher Gasbildung erhöht die Lebensdauer und Zuverlässigkeit der Batterie. So entsteht ein System, das für den Einsatz in sensiblen Umgebungen einsatzbereit ist. Langfristig entwerfen die Ingenieure Systeme, die Meerwasser als sicheren und unerschöpflichen Elektrolyten verwenden.

Das reduziert für die Industrie die Abhängigkeit von teuren chemischen Zusätzen. Die vereinfachte Herstellung dieser Batterien bringt die kommerzielle Nutzung in greifbare Nähe.

Auch interessant:

- So findest du heraus, was ChatGPT alles über dich weiß

- ChatGPT: Jugendschutz aktivieren – so geht’s

- Elektroauto: Was passiert, wenn die Batterie leer ist?

- Warum E-Autos auf der Autobahn mehr Energie verbrauchen

Der Beitrag Natrium-Ionen-Batterie: Wasser-Trick verdoppelt Leistung erschien zuerst auf BASIC thinking. Folge uns auch auf Google News und Flipboard oder abonniere unseren Newsletter UPDATE.